Fin janvier, Apple a fait chauffer la carte de crédit. La firme de Cupertino a jeté son dévolu sur Q.ai, une start-up israélienne, pour un montant de 2 milliards de dollars. Un record, ou presque, pour Apple dans ce domaine, alors que pour ses concurrents…

Apple achète Q.ai, petite startup israélienne pour 2 milliards de dollars

Alors, certes, le fondateur de cette start-up n’est pas un inconnu dans les couloirs de l'Apple Park. Aviad Maizels avait déjà revendu, il y a dix ans de cela, PrimeSense à la Pomme. Une acquisition capitale à l'époque, puisque sa technologie de capteurs 3D est devenue la pierre angulaire de Face ID. Mais la question est sur toutes les lèvres désormais : que va faire Apple des brevets de Q.ai ? Certains estiment que l’achat de cette pépite pourrait jouer un rôle majeur dans le développement des AirPods Ultra que nous évoquions hier.

AirPods Ultra : des caméras, mais pour quoi faire ?

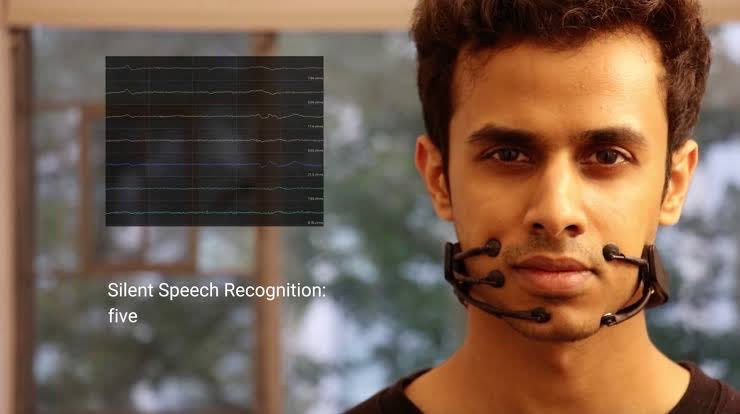

L'art de parler sans dire un mot

Le cœur de métier de Q.ai, c’est le machine learning appliqué à la compréhension de la parole "silencieuse" ou murmurée. Concrètement, leurs algorithmes sont capables d'analyser les micro-mouvements faciaux — ces infimes contractions musculaires autour de la bouche qui se produisent même quand on ne sort aucun son.

Couplée à une amélioration du traitement audio en milieu bruyant, cette technologie permettrait de comprendre l'utilisateur là où les micros classiques jettent l'éponge. Mais pour que la magie opère, il faut des yeux.

C’est ici que les pièces du puzzle s’assemblent. En juillet 2025, Apple a obtenu un brevet décrivant un système de caméras capable, à la manière du projecteur de points de Face ID, de cartographier un visage en 3D à très courte distance. Si le brevet restait flou sur l'appareil concerné, les rumeurs persistantes venant de la chaîne de production pointent toutes dans une direction : les AirPods.

L’analyste Ming-Chi Kuo affirmait déjà en 2024 qu'Apple prévoyait d'intégrer des caméras infrarouges dans les futurs AirPods Pro pour améliorer l'intégration avec le Vision Pro et permettre le contrôle par gestes. Entre-temps, le casque a quelque peu rétrogradé dans les priorités d’Apple. Plus récemment, le collectionneur de prototypes Kosutami en remettait une couche, évoquant une caméra par écouteur capable de "sentir" l’espace autour de l’utilisateur.

La fin du "malaise Siri" en public

La théorie qui lie ces deux fils rouges est simple : les caméras infrarouges des AirPods traqueraient les micro-mouvements du visage, tandis que le logiciel de Q.ai traduirait ces mouvements en texte ou en commandes.

Sur le papier, c’est une petite révolution ergonomique. Imaginez pouvoir dicter un iMessage ou demander un itinéraire à Siri dans un train bondé ou une rue bruyante, sans avoir à lever la voix ni même à chuchoter. Une manière comme une autre de protéger sa vie privée…

Un nouveau standard pour les "Wearables"

Les AirPods Pro ne seraient d'ailleurs pas les seuls bénéficiaires. Cette technologie de saisie silencieuse et privée pourrait être le chaînon manquant pour le Vision Pro ou les futures lunettes de réalité augmentée de la marque. Elle permettrait de réduire la dépendance aux commandes vocales bruyantes ou aux gestes de la main parfois fatigants.

Si l’on attendra de voir si ces AirPods Ultra transforment l'essai, l’investissement massif consenti pour Q.ai ne laisse que peu de place au doute : Apple veut faire disparaître l'interface. Jusqu’ici, le duo AirPods/Siri tenait souvent du rendez-vous manqué, la faute à un environnement bruyant, à la gêne de parler dans le vide, ou plus surement au fait que Siri était trop souvent à côté de la plaque. Avec la lecture labiale et une IA enfin douée d'entendement, Cupertino prépare un nouveau départ qui, s’il se concrétise, rendrait enfin nos écouteurs aussi intelligents qu'ils sont devenus indispensables