À quelques mois du lancement du Vision Pro, Apple met les petits plats dans les grands en matière de réalité augmentée. Avec iOS 17, il devient possible de scanner facilement un objet en 3D rien qu'avec son iPhone. Comment ? C'est ce que nous allons détailler dans cet article.

L'API Object Capture disponible sur iOS 17

Autant le préciser tout de suite, scanner en 3D un objet avec son iPhone n'est pas complètement nouveau, il existe différentes méthodes depuis des années. Vous pouvez par exemple utiliser l'application RealityScan d'Epic Games qui va vous demander de prendre des dizaines de photos de l'objet avant de les envoyer vers ses serveurs pour les assembler en un modèle 3D. Autre solution proposée par Apple depuis iOS 15 et macOS Monterey : prendre un paquet de photos avec votre iPhone puis les transférer sur Mac pour que celui-ci les transforme en un modèle 3D grâce à l'API Object Capture.

Mais il y a une nouveauté récente qui change beaucoup de choses : l'API Object Capture est disponible sur iOS 17. Cela signifie qu'il devient possible de réaliser, avec les outils d'Apple, un processus complet de photogrammétrie sur iPhone et iPad. Plus besoin de transférer les photos sur Mac ou sur un serveur pour la composition du modèle 3D, tout se fait en local, sur un seul et même appareil.

Cette API est la base de la nouvelle fonction de scan 3D de Reality Composer, l'application d'Apple spécialisée dans la réalité augmentée, mais elle est aussi accessible aux applications tierces (on y reviendra). Pour pouvoir en tirer parti du côté utilisateur, il y a une condition qui écarte une partie du public : il faut un iPhone équipé d'un LiDAR, c'est-à-dire un iPhone 12 Pro, 13 Pro, 14 Pro ou 15 Pro. Même chose sur iPad, il faut un modèle équipé d'un LiDAR, à savoir un iPad Pro 2020 au minimum.

Apple requiert ce scanner 3D car il est mis à profit pour combler les lacunes des clichés en deux dimensions : si vous essayez de scanner une chaise de couleur uniforme rien qu'avec l'appareil photo, l'iPhone aura du mal à différencier le siège du dossier. En prenant en compte les données de profondeur enregistrées par la LiDAR, la modélisation 3D devient d'un coup beaucoup plus fiable. L'adjonction du LiDAR permet donc à l'API d'Apple de scanner plus d'objets qu'elle ne le faisait précédemment, même si certains (ceux qui sont réfléchissants ou transparents) posent toujours des difficultés.

Un essai avec Reality Composer

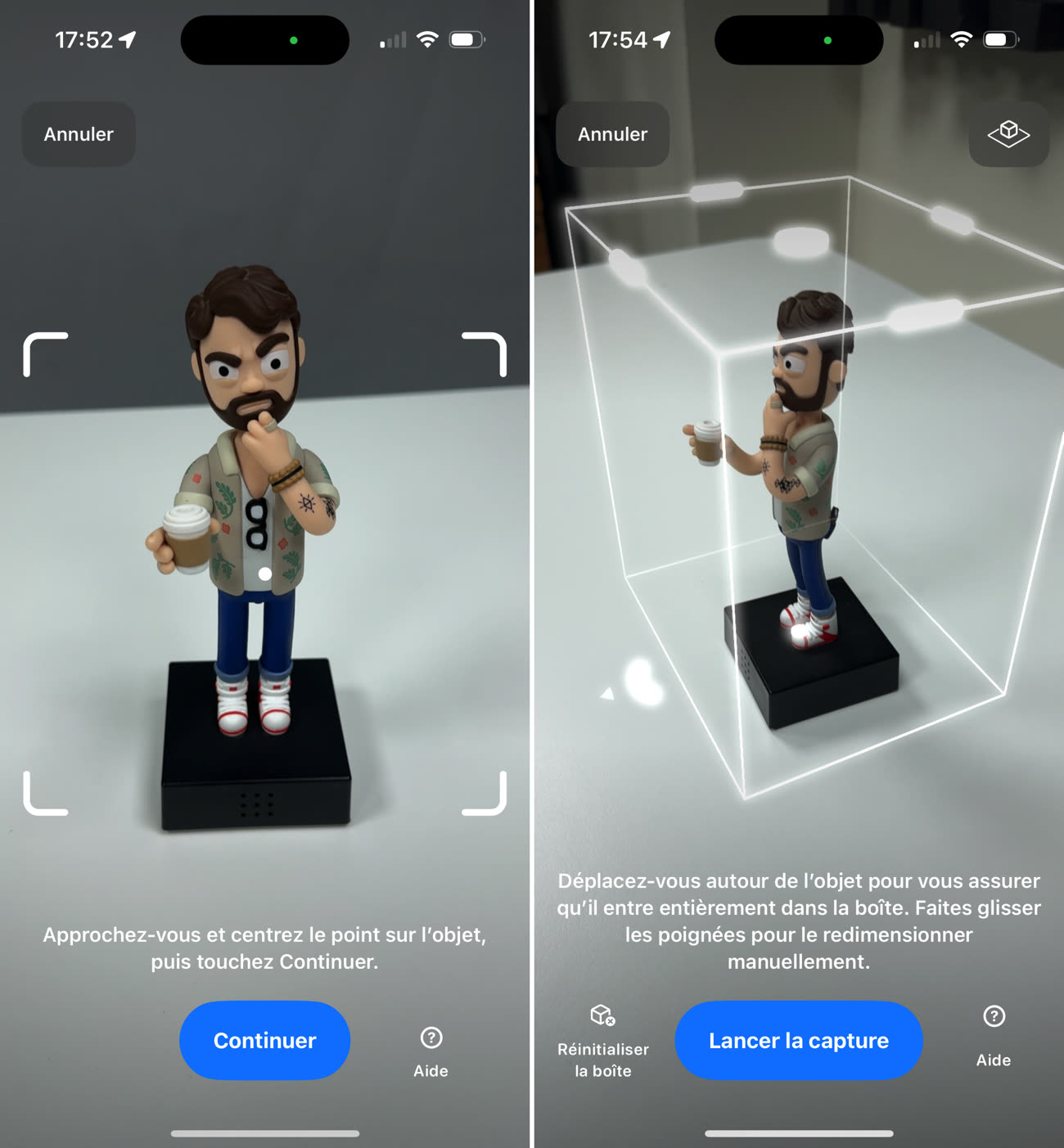

Proposée gratuitement par Apple, l'application Reality Composer est la solution standard pour scanner des objets en 3D grâce à l'API Object Capture d'iOS 17. Avant toute chose, pour réaliser efficacement la modélisation, il faut se trouver dans un environnement lumineux et pouvoir tourner autour de l'objet. Une fois qu'on a autorisé Reality Composer à accéder à l'appareil photo, on commence par pointer l'objet puis on forme une boîte virtuelle autour de lui.

Quand la boîte englobe bien l'objet, on peut passer au processus de scan à proprement parler. Il faut tourner doucement autour de l'objet tout en faisant en sorte de le garder au centre de l'image. Contrairement à RealityScan qui demande de prendre des dizaines des photos manuellement, la capture est ici automatisée : les photos sont prises de manière transparente au fur et à mesure que l'on tourne autour du sujet.