Incroyable mais vrai, Apple a oublié de faire de la retape pour la réalité augmentée lors du keynote de la WWDC 2020. Que les nombreux amateurs d'AR se rassurent, il y a toutefois des nouveautés dans le domaine, des nouveautés importantes même.

Ancres de localisation

ARKit 4 introduit des ancres de localisation qui permettent de placer du contenu en réalité augmentée dans le monde réel, avec de vraies coordonnées géographiques. Ainsi, les différents utilisateurs d'une même app pourront voir le même objet virtuel à la même place dans le monde réel, comme une statue virtuelle dans une rue. ARCore, l'équivalent d'ARKit chez Google, dispose d'un système d'ancres similaire.

Le système d'ancres de localisation d'ARKit 4 demande au minimum un iPhone XS ou XR, sans doute car il exploite des procédés de machine learning afin de déterminer où se trouve précisément l'appareil dans l'environnement.

Ces ancres ne fonctionneront que dans certaines villes américaines pour commencer (San Francisco, New York, Los Angeles, Chicago, Miami et d'autres à venir cet été), car elles ont besoin de données géographiques précises disponibles dans Plans.

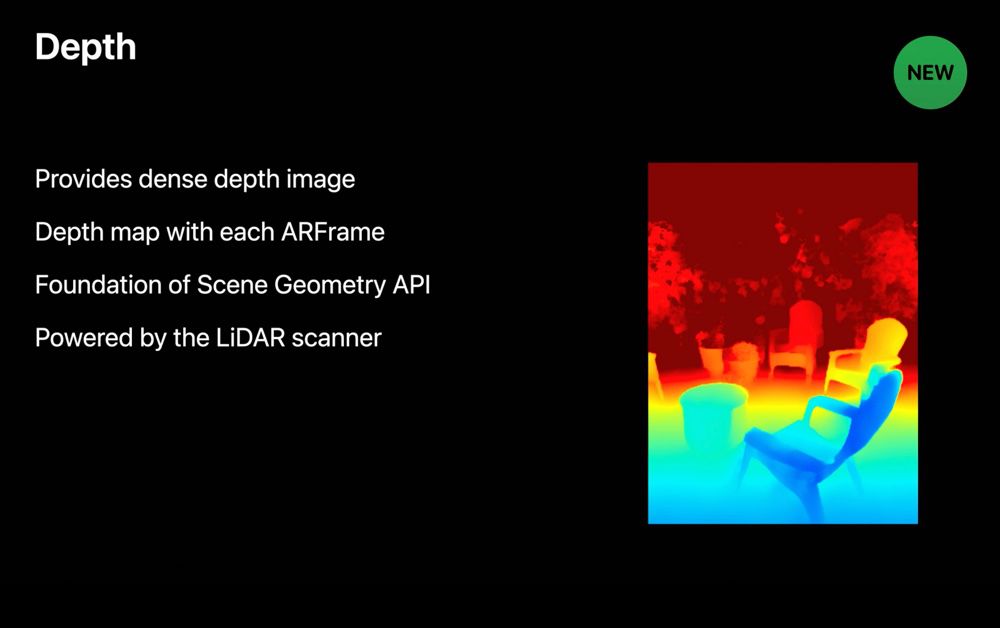

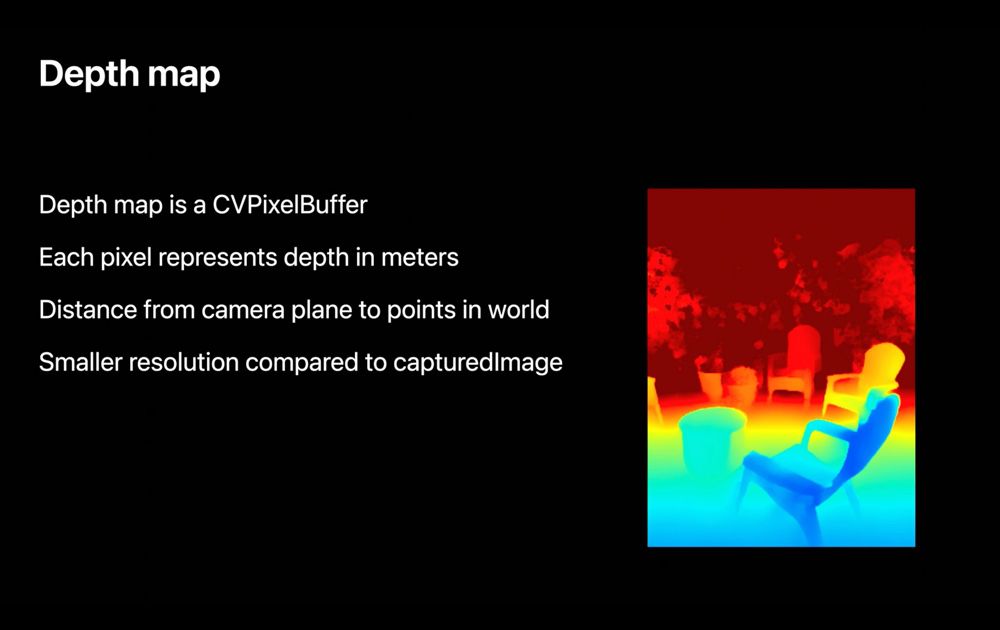

API de profondeur

ARKit 4 apporte également une API supplémentaire. Sorti en même temps que les iPad Pro 2020 équipés d'un LiDAR, ARKit 3.5 permettait aux développeurs d'exploiter la carte topographique (API Scene Geometry) d'une pièce avec ses différents éléments (plancher, murs, plafond, fenêtres, portes, chaises…). ARKit 4 rend disponible l'API qui sous-tend cette fonction, l'API de profondeur (Depth API).

Grâce aux données de profondeur, les applications de réalité augmentée pourront se montrer plus précises pour placer les objets ou gérer l'occlusion sur les terminaux équipés d'un LiDAR — seulement les iPad Pro 2020 pour l'heure, mais l'iPhone devrait y avoir droit un jour.

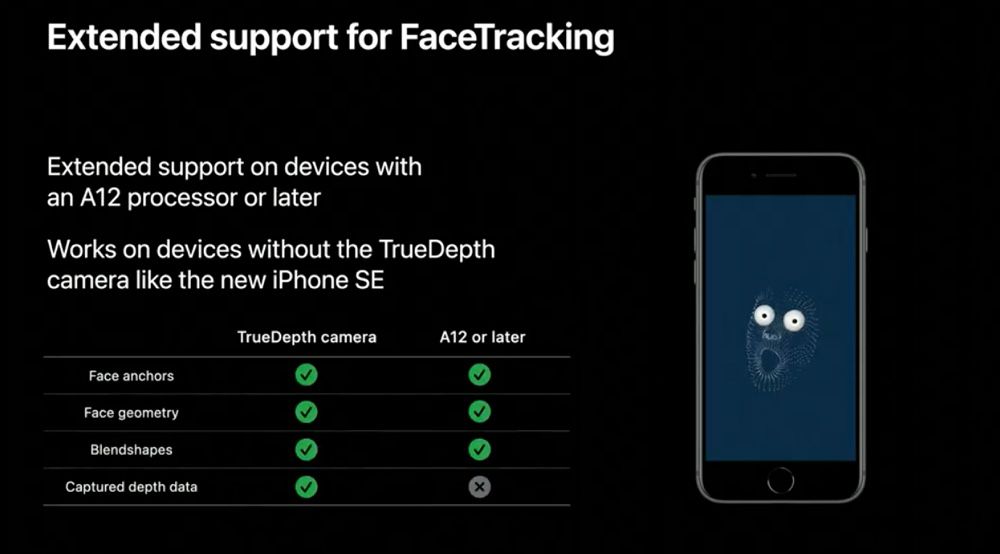

Suivi du visage sur l'iPhone SE 2020 et les autres appareils A12 sans TrueDepth

La fonction de suivi du visage, qui sert notamment aux Memoji, n'a plus besoin de caméra TrueDepth du moment que l'appareil est équipé d'une puce A12. Apple cite uniquement l'iPhone SE 2020 en exemple, mais cela devrait aussi concerner l'iPad Air 3 et l'iPad mini 5.

Cette nouveauté va dans le sens des rumeurs parlant de futurs iPhone sans Face ID : ces iPhone pourraient faire une croix sur la caméra TrueDepth (Face ID serait remplacé par un Touch ID plus moderne sous l'écran), sans toutefois perdre des fonctions annexes, comme les Memojis. À moins que cette avancée ne serve aux Mac équipés de puces Apple.

Mise à jour : précision sur la compatibilité de la fonction Face Tracking.