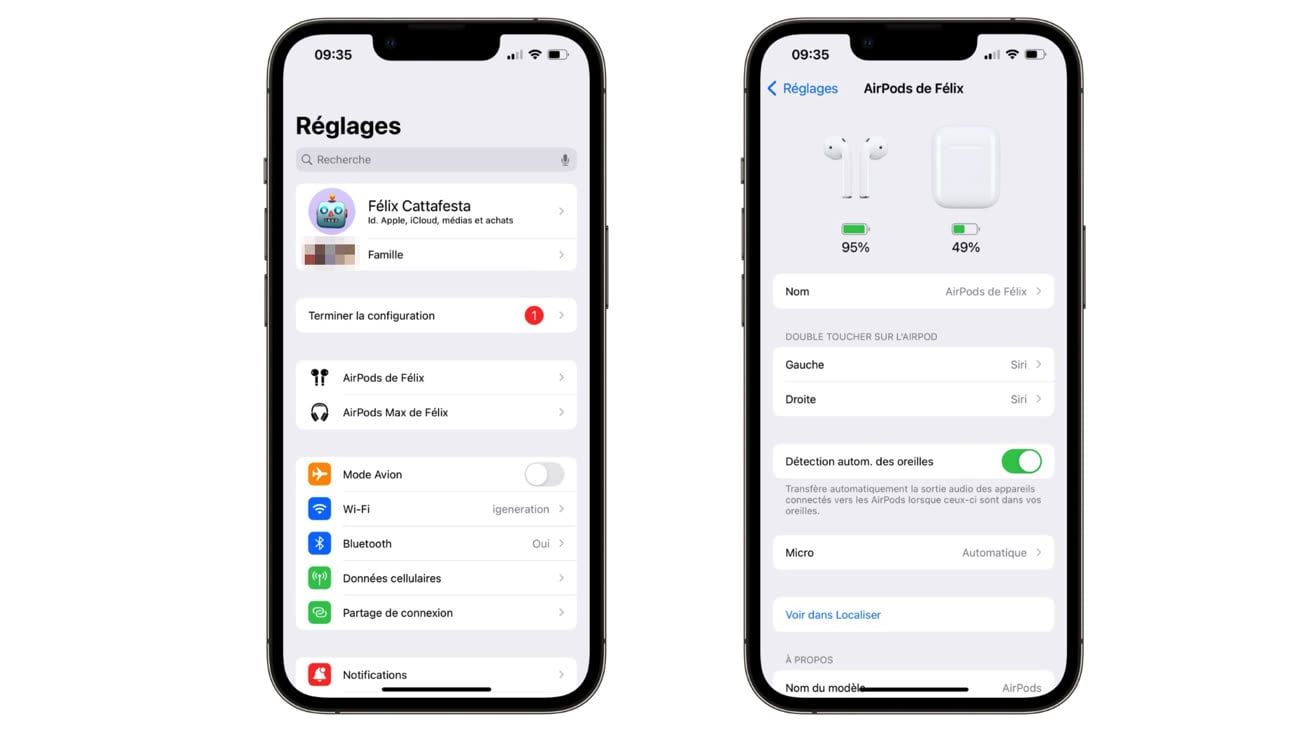

Apple a revu l'interface de gestion des AirPods dans iOS 16. Un nouvel onglet est mis en évidence dans les Réglages lorsque des écouteurs sont connectés, permettant de modifier l'ensemble des paramètres habituels (réduction de bruit, connexion au réseau Localiser, accessibilité…). Un ajout bien pratique qui fait gagner un peu de temps, car il fallait auparavant aller dans Bluetooth et appuyer sur le petit i à côté de ses AirPods.

Une image de l'appareil connecté s'affiche désormais en haut de l'onglet accompagné du niveau de batterie. Dans le cas des AirPods et AirPods Pro, on pourra également voir la charge restante au boîtier avant que les écouteurs n'aient été enlevés. Rappelons que l'écrin des AirPods n'est pas Bluetooth, ce qui fait que le pourcentage de batterie ne peut pas être indiqué en temps réel. Si ce changement est bienvenu, reste une petite déception : on ne peut toujours pas choisir de mettre à jour manuellement ses écouteurs. Notons que ce nouveau menu est aussi disponible avec certains appareils Beats.

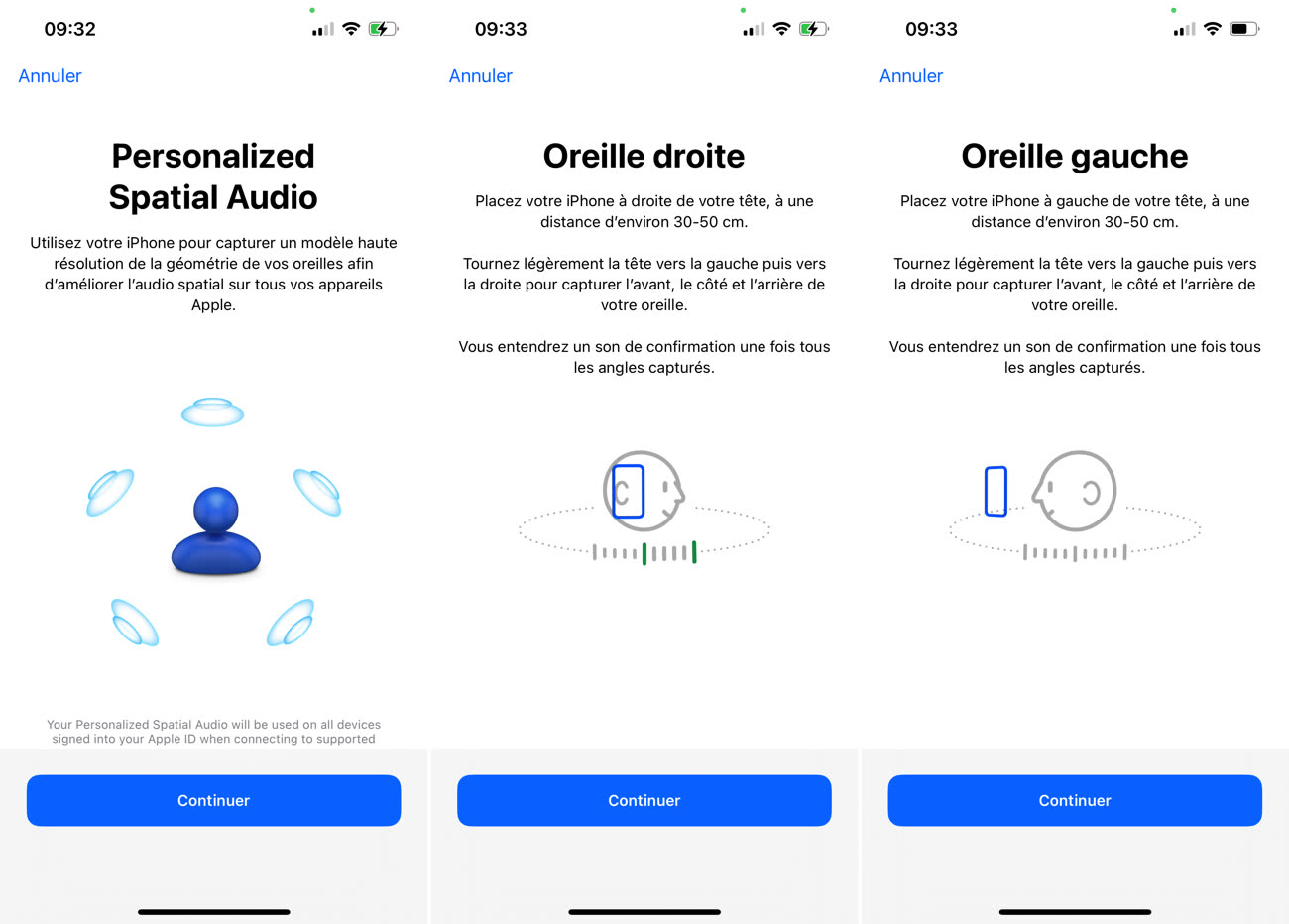

Mais iOS 16 apporte surtout l'audio spatial personnalisé, qui promet d'améliorer la lecture de musique ou le visionnage de films en offrant une expérience plus précise. La fonction utilise la caméra TrueDepth du téléphone et il faudra un iPhone XS ou plus pour en profiter. Actuellement, cette nouveauté n'est pas disponible sur les iPad Pro avec Face ID.

La mise en place de cette fonction se trouve dans l'onglet AirPods des Réglages, rubrique « Set Up Personalized Spatial Audio » (le menu n'a pas encore été traduit). L'utilisateur est invité à refaire un scan de sa tête, puis à capturer un modèle de ses oreilles. Pour cela, il va devoir placer l'iPhone à droite et à gauche de sa tête le temps que la caméra capture l'empreinte.

Le procédé est simple sur papier, mais parfois un peu buggé : ça a fonctionné du premier coup sur mon iPhone 13 Pro, mais j'ai du m'y reprendre à plusieurs fois sur un iPhone 13 car iOS ne voulait pas scanner entièrement mon oreille. Au niveau de l'expérience, l'audio spatial est bel et bien amélioré même si la différence n'est pas sensationnelle sur mes AirPods Max.